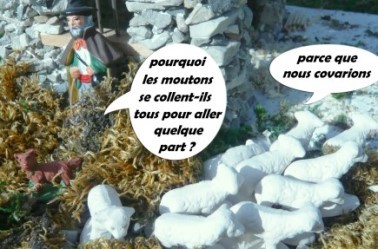

Covariance et matrice de variances-covariances

La covariance n’est pas un indicateur final : on ne la retrouve pas sur le tableau de bord du manageur. Elle constitue toutefois un rouage essentiel de toute la machinerie statistique.

Outil créé par le Britannique Ronald Fisher, la covariance mesure la liaison linéaire qui peut exister entre un couple de variables statistiques ou un couple de variables aléatoires quantitatives.

Formules

En respectant les écritures habituellement en vigueur, distinguons les deux types de variables.

Couple de variables statistiques \(x\) et \(y\) : on l'écrit \(\rm{Cov}(x,y)\) ou \(σ_{xy}\) ou encore avec des majuscules (mais nous le réserverons aux variables aléatoires).

Pour une population de taille \(N,\) les formules sont les suivantes...

Si l'on dispose de données en liste (individuelles) :

\({\sigma _{xy}}\) \(=\) \(\displaystyle{\frac{1}{N}\sum\limits_{i = 1}^N {\left( {{x_i} - {\mu _x}} \right)\left( {{y_i} - {\mu _y}} \right)}} \)

La parenté avec la variance est évidente. D'ailleurs, la covariance d’une variable avec elle-même (autocovariance) est tout simplement la variance. \(\rm{Cov}(x,x) = V(x).\) Donc, faisons un parallèle avec le théorème de König : la covariance est la moyenne du produit des valeurs de deux variables moins le produit des deux moyennes.

\(\rm{Cov}(x,y)\) \(=\) \(\displaystyle{\frac{1}{N}\sum_{i=1}^n x_iy_i - (\overline{x} \times \overline{y}})\)

Cette deuxième technique est utilisée en page de calculs des paramètres d'une régression simple tandis que la première l'est en page de calcul de la covariance. Les deux sont comparées en page d'exemple d'ajustement linéaire.

Si les données apparaissent sous forme de tableau de contingence :

\(\rm{Cov}(x,y)\) \(=\) \(\displaystyle{\sum_{i=1}^k \sum_{j=1}^l f_{ij} (x_i - \overline{x})(y_i - \overline{y})}\)

À l'instar de la variance, il existe un biais si l'on calcule la covariance sur un échantillon aléatoire de taille \(n\) dans le but de l'extrapoler à la population. On doit alors calculer une covariance sans biais :

\(s_{xy}\) \(=\) \(\displaystyle{\frac{1}{n-1} \sum_{i=1}^n (x_i - \overline{x})(y_i - \overline{y})}\)

Couples de variables aléatoires \(X\) et \(Y\) : \(\rm{Cov}(X,Y)\) \(=\) \(E(XY) - [E(X) × E(Y)]\)

Interprétation

Si deux variables sont indépendantes, leur covariance est nulle. Mais la réciproque est fausse: il peut exister une dépendance non linéaire qui se traduit également par une covariance nulle. Donc, attention aux conclusions hâtives...

Si deux variables évoluent généralement dans le même sens, la covariance est de signe positif (exemple : température extérieure et consommation de crèmes glacées). Si elles évoluent dans le sens contraire, la covariance est négative (exemple : température extérieure et consommation de chauffage).

Emploi

Si la covariance n’est pas un indicateur final, c’est parce qu’elle mesure le lien de variables qui ne sont pas nécessairement comptabilisées dans la même unité. Pour revenir à notre exemple, \(X\) peut être mesurée en degrés et \(Y\) en nombre de glaces. Présentée telle quelle, la covariance ne signifie rien. Sauf si… Divisée par le produit des écarts-types, elle est alors standardisée et on peut la situer sur une échelle qui signifie quelque chose : elle s’est métamorphosée en coefficient de corrélation linéaire.

Une covariance ne s’applique pas nécessairement à toutes les valeurs, ce qui permet de calculer, même sur une simple série chronologique, des covariances entre certains groupes de valeurs (exemple du corrélogramme).

Propriétés

Enfin, la covariance possède des propriétés importantes mais qui passent inaperçues dans la vie quotidienne :

- \(\rm{Cov}(X,Y) = \rm{Cov}(Y,X)\)

- \(\rm{Cov}(X+\rm{constante},Y)\) \(=\) \(\rm{Cov}(X,Y)\)

- \(\rm{Cov}(aX,Y)\) \(=\) \(a \rm{Cov}(X,Y)\) donc \(\rm{Cov}(aX,bY)\) \(=\) \(ab \rm{Cov}(X,Y)\)

- Une autre propriété est la simple application d'une identité remarquable : \(\rm{Var}(X+Y)\) \(=\) \(\rm{Var}(X)\) \(+\) \(\rm{Var}(Y)\) \(+\) \(2 \rm{Cov}(X,Y)\)

- \(\rm{Var}(aX + bY)\) \(=\) \(a^2\rm{Var}(X)\) \(+\) \(2ab \rm{Cov}(X,Y)\) \(+\) \(b^2 \rm{Var}(Y)\)

Matrices des variances-covariances

Maintenant, situons-nous dans le cas de deux variables. On peut alors calculer les covariances de chaque couple de variables puis les indiquer dans un tableau carré, et symétrique puisque \(\rm{Cov}(X,Y) = \rm{Cov}(Y,X).\) En diagonale, on trouve évidemment les variances.

Cette matrice travaille en coulisses et si un logiciel vous la restitue, elle ne sera pas d’une utilité vitale. Lorsqu’elle est réduite (écarts-types = 1), elle est égale à la matrice des corrélations et devient davantage opérationnelle.

La matrice de variances-covariances intervient dans l’établissement de plusieurs méthodes d’analyses multivariées assez proches les unes des autres.

Cette matrice, ou plutôt son inverse, permet de déterminer les coefficients de régression multiple lorsqu’on la multiplie à la matrice colonne des covariances entre les \(X_i\) et les \(Y_j.\)

La matrice de variances-covariances des résidus, quant à elle, doit être égale à la matrice unité (des 0 partout sauf des 1 en diagonale) si les conditions de décorrélation et d’homoscédasticité sont parfaitement remplies.

L’AFD est une régression multiple particulière et se construit donc aussi sur la décomposition de la matrice des variances-covariances (intra-classes et entre les barycentres de classes).

La matrice des variances-covariances est utilisée dans le cadre des ACP non normées alors que la matrice des corrélations l’est, fort logiquement, dans le champ des ACP normées.